[Debatte] Dass „Künstliche Intelligenz“ nicht automatisch auch moralisch angemessen handelt, ließ sich bereits 2016 beim Microsoft-Programm Tay beobachten. Der „Rassistische Chat-Roboter“, wie die Medien damals titelten, bekam nun Gesellschaft. Die Artificial Intelligence (AI), die im Kunst-Projekt ImageNet Roulette zum Einsatz kam, zeigte, dass sich Rassismus, Vorurteile und Stereotypisierungen nicht nur im analogen Leben finden lassen. Maschinen lernen von Menschen und sorgen dafür, dass auch in der digitalen Welt kein Grund zur Hoffnung besteht. Ein Problem, auf das der Künstler Trevor Paglen und die AI-Forscherin Kate Crawford in einer aktuellen Ausstellung aufmerksam machen.

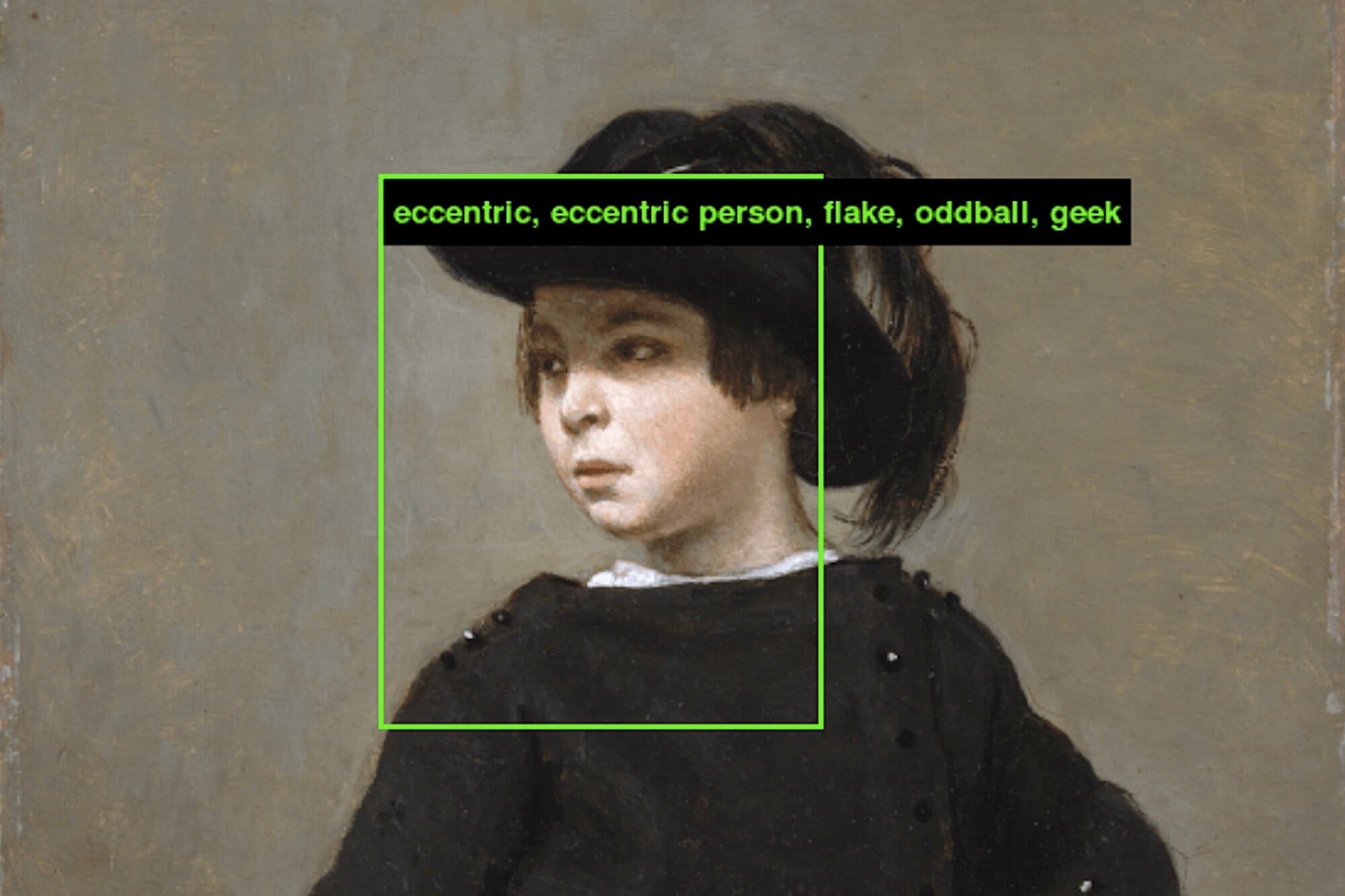

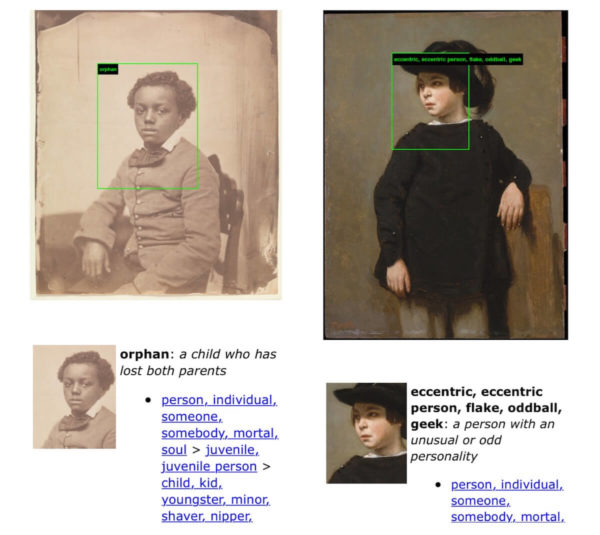

Portrait eines Jugendlichen (um 1850/60) – Metropolitan Museum of Artund Camille Corot, Portrait eines Kindes (um 1835) – Metropolitan Museum of Art, beide Public Domain (Ergebnisse aus imagenet-roulette.paglen.com)

Von den Online-Trollen lernen

Als Microsoft den Chatbot Tay auf die Twitter-Community losließ, hatte sich das Unternehmen vermutlich eine eher langlebigere Maschine-Mensch-Interaktion erhofft. Hinter Tay stand eine Art „Künstliche Intelligenz“, die mit der Zeit lernen und damit klüger werden sollte. Jede Interaktion hätte für das Programm eine Bereicherung sein können, theoretisch. Die Basis des Chatbots bildeten „modellierte, gereinigte und gefilterte Daten“. Kaum bei Twitter aktiv, baute sich eine neue Datenmenge auf – voll mit moralisch zweifelhaften bis hin zu extremistischen Inhalten. Von Antisemitismus über Hass gegen Frauen bis hin zu Verschwörungstheorien, war Tay inhaltlich schnell inmitten der Siff-Twitter-Community angekommen. Microsoft nahm den Bot schnell wieder offline. Man hätte die Entwicklungen nicht vorhersehen können, hieß es in einem Statement gegenüber der Öffentlichkeit.

Aber hätte man nicht eigentlich damit rechnen müssen, dass Tay bei Twitter sehr schnell von anderen Nutzern „lernen“ würde, Donald Trump ebenso zu verehren wie Hitler? Hatte man bei Microsoft mit einem wissenschaftlich kontrollierbaren System gerechnet, in dem der Bot einer ausgewogenen Pluralität von Meinungen ausgesetzt sein würde? Die „lernfähige Maschine“ lernt von jedem und übernimmt Theorien und Meinungen ohne vorherige moralische Bewertung. So wurde Tay letztendlich nicht zu einem Spiegel der gesamten Gesellschaft, wohl aber zu einem Abbild der radikalen Troll-Community bei Twitter.

Artificial Intelligence in der Bild-Analyse

Das Metropolitan Museum of Art (Met) begann 2018 mit einer Reihe von AI-basierten Projekten, um Kunstwerke einem breiteren Publikum zugänglich zu machen. Ein Beispiel ist das Projekt, „Tag, That’s IT!“. Es zielt auf die größere Verbreitung von Public Domain Bildern via Wikimedia Commons ab, und zwar durch eine bessere Auffindbarkeit für Nutzer durch umfangreiche Verschlagwortung (engl.: tag). Bei der Generierung genauerer Schlagworte kam eine AI zum Einsatz – wobei die AI zuvor von Kategorien lernen musste, in die Menschen bestimmte Werke eingeordnet hatten. Wurden etwa von den Nutzern eine ausreichende Anzahl an Gemälden mit dem Schlagwort „junge Frau“ versehen, kann die AI auf dieser Grundlage ähnlich aussehende Bilder auch mit diesem Schlagwort markieren.

Die „Künstliche Intelligenz“ orientiert sich in ihrem Handeln also immer an Informationen, die Menschen zuvor zur Verfügung gestellt haben. Was dies im Bereich der Bild-Analyse bedeutet, zeigte vor kurzem der Künstler Trevor Paglen in einem gemeinsamen Projekt mit der AI-Forscherin Kate Crawford. Als Basis für ihr 2019 gestartetes Projekt ImageNet Roulette diente den beiden die Bild-Datenbank ImageNet, in der Bilder mit hierarchisch gegliederten Substantiven (auf Basis des Princeton-Angebots WordNet) verschlagwortet sind. Die seit 2009 bestehende Datenbank soll eigentlich als Ressource für Wissenschaftler, Pädagogen oder Schüler genutzt werden. Ein guter Grund für Paglen und Crawford, sich näher mit ImageNet zu beschäftigen. Ihr Kunst-Projekt blieb nicht folgenlos. Wie ImageNet Ende September 2019 bekannt gab, sollten rund 600.000 Bilder von Personen aus der Datenbank entfernt werden. Der Grund: Mit ihrem Kunst-Projekt konnten Paglen und Crawford aufdecken, dass die Verschlagwortung in der Datenbank diskriminierend ist. Eine AI, die auf dieser Datenbasis lernt, würde die Diskriminierung von Menschen auch online weiter verfestigen.

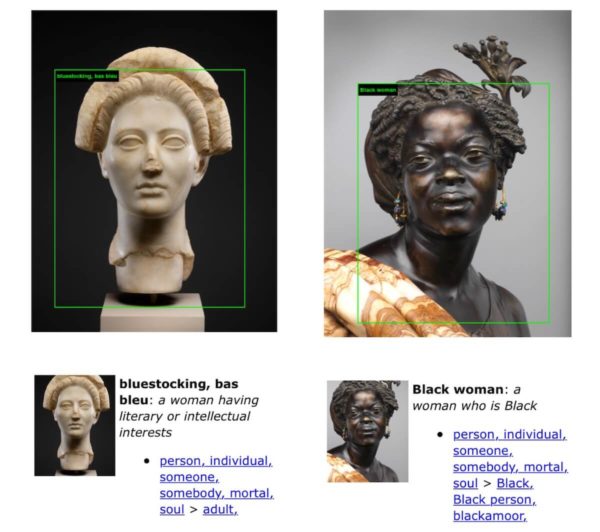

Marmorbüste einer jungen Frau (ca. 98-117 v. Chr., römisch) – Metropolitan Museum of Art und Charles-Henri-Joseph Cordier, La Capresse des Colonies (1861) – Metropolitan Museum of Art, beide Public Domain (Ergebnisse aus imagenet-roulette.paglen.com)

Mechanische Türken als Lehrer

Die Datenbasis von ImageNet umfasst etwa 14 Millionen Bilder. Diese wurden von Amazon-Mitarbeitern kategorisiert, von sogenannten „Mechanischen Türken“. Der Begriff geht auf einen vermeintlichen Schachroboter des Konstrukteurs Wolfgang von Kempelen aus dem Jahr 1769 zurück. Da der Roboter wie ein Türke gekleidet war, etablierte sich der Name „Schachtürke“. Im Inneren des Apparats befand sich aber keine Mechanik, sondern einfach ein Schach-spielender Mensch. Der Schwindel wurde letztendlich aufgedeckt, doch zunächst ließ sich das Publikum täuschen. Viele glaubten an eine echte, vom Menschen geschaffene „Künstliche Intelligenz“.

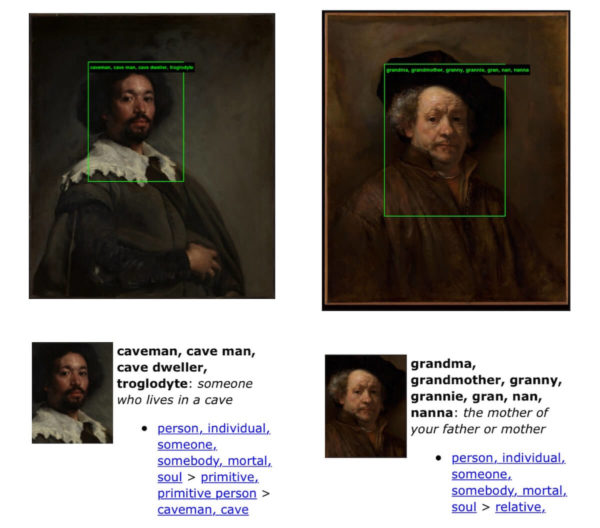

Heute werden Menschen als Mechanical Turks bezeichnet, wenn sie eine technische Dienstleistung übernehmen, die noch nicht von einem Computerprogramm ausgeführt werden kann. Ein Beispiel ist die Verschlagwortung von Bildern. „Mechanische Türken“ müssen hier zunächst von Hand eine Datenbasis schaffen, auf deren Grundlage eine AI später lernen kann. Und hier liegt das Problem, auf das Paglen und Crawford mit ihrem Projekt hinweisen konnten: Menschen denken diskriminierend. Dies wird besonders deutlich, wenn Menschen damit beauftragt werden, Bilder von anderen Menschen in Kategorien einzuordnen. Die Mechanical Turks versahen die 14 Millionen Bilder bei ImageNet mit 2.833 Unterkategorien zur Kategorie „Person“, inklusive Angaben zur Ethnie, Nationalität, Beruf, sozialer Schicht, Verhalten, Charakter und sogar Moralvorstellungen. Vorurteile von Menschen werden so zur Datenbasis für AI – eine rassistische „Künstliche Intelligenz“ entsteht.

ImageNet Roulette: Schwarz ist Schwarz

Die Ergebnisse ihrer Arbeit zu ImageNet zeigen Trevor Paglen und Kate Crawford aktuell in der Ausstellung „Training Humans“, die vom 12. September 2019 bis 24. Februar 2020 in der Fondazione Prada in Mailand zu sehen ist. Bis zum 27. September 2019 konnten Nutzer auf einer Website auch selbst testen, welche Schlagworte ihrem Foto von der AI zugeordnet werden. Schnell füllten sich Soziale Netzwerke mit Screenshots von ImageNet Roulette die zeigten, dass die Selfies teils diskriminierend oder völlig absurd kategorisiert wurden. Besonders Schwarze Menschen hatten geringe Chancen, von ImageNet Roulette mit einer anderen Bezeichnung als „Schwarz“ versehen zu werden. Davon abweichende Schlagworte waren meist beleidigend.

Die Folgen dieses AI-Trainings können nicht nur auf persönlicher Ebene unangenehm für Individuen sein, sondern auch gesellschaftlich schwerwiegend. Immerhin findet diese Technologie auch Anwendung in Software zur Gesichtserkennung, die von Polizei und Behörden in Zukunft vielleicht nicht nur zur Überwachung öffentlicher Orte, sondern auch zur Einstufung von möglichen Gefährdungslagen genutzt werden kann. Wenn die Grundlage der Kategorisierung von Menschen Rassismus ist, wird die Technologie zur Bedrohung von ganzen Gruppen in der Bevölkerung. Auf diese Probleme machen Paglen und Crawford mit ihrer Arbeit aufmerksam. Gegenüber Art Newspaper betonte Paglen: „Die Ausstellung zeigt, wie diese Bilder Teil einer langen Tradition der Erfassung von Bildern von Menschen ohne ihre Zustimmung sind. Sie werden klassifiziert, segmentiert und oft stereotypisiert. Dies erinnert an koloniale Projekte aus der Vergangenheit“.

Velázquez, Juan de Pareja (1650) – Metropolitan Museum of Art und Rembrandt, Selbstportrait (1660) – Metropolitan Museum of Art, beide Public Domain (Ergebnisse aus imagenet-roulette.paglen.com)

Training Humans: Die Gefahren der AI

„Training Humans“ beschäftigt sich insbesondere mit zwei grundlegenden Fragen: Die Ausstellung untersucht zum einen, wie Menschen in AI-Trainingsdatensätzen dargestellt, kategorisiert und kodifiziert werden. Zum anderen wird gezeigt, wie technologische Systeme dieses Material gewinnen, kennzeichnen und nutzen. Da die Klassifikationen der Menschen durch AI-Systeme invasiver und komplexer werden, lassen sich immer deutlicher auch Probleme und Gefahren für die Gesellschaft erkennen, insbesondere für bestimmte marginalisierte Gruppen.

Technologiekonzerne trainieren AI-Systeme bereits darauf, den Gesichtsausdruck von Menschen zu erkennen und anhand dessen vielleicht die psychische Gesundheit zu analysieren oder festzustellen, ob eine Person ein Verbrechen begehen wird. Vor diesem Hintergrund stellen Trevor Paglen und Kate Crawford auch die Frage, wo die Grenzen zwischen Wissenschaft, Geschichte, Politik, Vorurteilen und Ideologie in der „Künstlichen Intelligenz“ liegen. Und schließlich muss auch die Frage diskutiert werden, wer die Macht hat, diese Systeme aufzubauen und zu nutzen.

Kate Crawford und Trevor Paglen : Training Humans

Fondazione Prada, Mailand

12.09. 2019 – 24.02.2020

Mehr zum Forschungs- und Kunst-Projekt von Kate Crawford und Trevor Paglen: Excavating AI. The Politics of Images in Machine Learning Training Sets

Trevor Paglen: From Apple to Anomaly (Pictures and Words)

Barbican Center, London

26.09.2019 – 16.02.2020

Header-Bild: Camille Corot, Portrait eines Kindes (um 1835) – Metropolitan Museum of Art, Public Domain

Wir brauchen deine Unterstützung

Werde jetzt Mitglied im musermeku Freundeskreis: Erhalte wöchentlich News zu Kunst und Kultur direkt per E-Mail, sichere dir den Zugang zu exklusiven Inhalten und hilf uns dabei, unsere Betriebskosten für musermeku.org zu decken.

Bei musermeku schreibt Dr. Angelika Schoder über Themen zur Digitalisierung, über Museen und Ausstellungen sowie über Reise- und Kultur-Tipps.

Linktipps

Der Newsletter zu Kunst & Kultur

In unserem kostenlosen Newsletter informieren wir einmal im Monat über aktuelle Neuigkeiten aus dem Kunst- und Kulturbereich.